چرا هزینه ذخیرهسازی کلانداده زیاد است؟

هزینهها فقط مربوط به خرید دیسکهای سخت (HDD) یا حافظههای پرسرعت (SSD) نیست. هزینههای پنهان و آشکار دیگری نیز وجود دارد:

- هزینه سختافزار: سرورها، رکها و تجهیزات شبکه.

- هزینه نگهداری: برق، خنککننده، فضای فیزیکی دیتا سنتر.

- هزینه نرمافزار: لایسنس پلتفرمها و ابزارها.

- هزینه نیروی انسانی: متخصصان برای مدیریت و نگهداری زیرساخت.

- هزینه تکثیر داده (Data Replication): برای اطمینان از دسترسپذیری و جلوگیری از حذف دادهها، معمولاً چندین نسخه از دادهها نگهداری میشود (مثلاً در HDFS به طور پیشفرض ۳ نسخه).

استراتژیهای کلیدی برای کاهش هزینهها

این استراتژیها را میتوان به سه دسته اصلی تقسیم کرد: حاکمیت داده، بهینهسازی تکنولوژیک و رویکردهای معماری.

دسته اول: مدیریت و حاکمیت داده (Data Governance)

این استراتژیها بر “چه چیزی” و “تا چه زمانی” ذخیره شود، تمرکز دارند.

-

مدیریت چرخه عمر داده (Information Lifecycle Management – ILM):

همه دادهها ارزش یکسانی ندارند و این ارزش با گذشت زمان تغییر میکند. با پیادهسازی ILM، دادهها را به صورت خودکار بین لایههای مختلف ذخیرهسازی جابجا میکنید:- لایه داغ (Hot Tier): دادههایی که به طور مکرر و سریع به آنها نیاز است. این دادهها روی حافظههای گرانقیمت و سریع (مانند SSD یا In-Memory) ذخیره میشوند.

- لایه گرم (Warm Tier): دادههایی با دسترسی کمتر. این دادهها روی دیسکهای سخت استاندارد (HDD) ذخیره میشوند.

- لایه سرد (Cold Tier / Archive): دادههای تاریخی که به ندرت به آنها نیاز است اما باید برای مقاصد قانونی یا تحلیلی نگهداری شوند. این دادهها روی سیستمهای ذخیرهسازی بسیار ارزان و کند (مانند Tape یا Object Storage های ارزانقیمت) آرشیو میشوند.

-

سیاستهای نگهداری داده (Data Retention Policies):

مشخص کنید که هر نوع داده تا چه زمانی باید نگهداری شود. بسیاری از دادهها (مانند لاگهای موقت) پس از چند ماه ارزش خود را از دست میدهند و میتوان آنها را به طور کامل حذف کرد. این کار به تنهایی میتواند حجم دادهها را به شدت کاهش دهد. -

دادهزدایی (Deduplication):

بسیاری از سیستمهای ذخیرهسازی مدرن، قابلیت شناسایی و حذف بلوکهای تکراری داده را دارند. با فعالسازی این قابلیت، از ذخیرهسازی نسخههای متعدد از یک فایل یا داده یکسان جلوگیری میشود. -

حذف دادههای زائد و بیکیفیت (Data Pruning):

یک فرآیند منظم برای شناسایی و حذف دادههایی که دیگر کاربردی ندارند، ناقص هستند یا کیفیت لازم برای تحلیل را ندارند، ایجاد کنید.

دسته دوم: بهینهسازی تکنولوژیک (Technological Optimization)

این استراتژیها بر “چگونه” ذخیره کردن دادهها تمرکز دارند.

-

فشردهسازی داده (Data Compression):

این یکی از مؤثرترین روشهاست. الگوریتمهای فشردهسازی مانند Snappy، Gzip یا Zstandard (Zstd) میتوانند حجم دادهها را بین ۳۰٪ تا ۸۰٪ کاهش دهند.- نکته: انتخاب الگوریتم مناسب یک بدهبستان (Trade-off) بین سرعت فشردهسازی و نرخ فشردهسازی است. Snappy سریعتر است اما نرخ کمتری دارد؛ Gzip نرخ بالاتری دارد اما کندتر است.

-

استفاده از فرمتهای ذخیرهسازی ستونی (Columnar Formats):

برای دادههای تحلیلی، به جای فرمتهای سطری (مانند CSV یا JSON)، از فرمتهای ستونی مانند Apache Parquet یا Apache ORC استفاده کنید.- مزایا:

- فشردهسازی بسیار بهتر: چون دادههای یک ستون از یک نوع هستند (مثلاً همه عدد یا همه تاریخ)، بسیار بهتر فشرده میشوند.

- سرعت بالاتر کوئریها: در کوئریهای تحلیلی، فقط ستونهای مورد نیاز خوانده میشوند که باعث کاهش شدید I/O میشود.

- نتیجه: با تبدیل دادهها به Parquet، هم در هزینه ذخیرهسازی و هم در هزینه پردازش صرفهجویی میکنید.

- مزایا:

-

انتخاب سیستم ذخیرهسازی مناسب (Right Storage System):

- HDFS (Hadoop Distributed File System): برای پردازشهای دستهای (Batch) بزرگ مناسب است، اما فاکتور تکثیر (Replication Factor) پیشفرض آن (۳) هزینه را سه برابر میکند. میتوان این فاکتور را برای دادههای کماهمیتتر به ۲ کاهش داد.

- ذخیرهسازهای شیء (Object Storage): سیستمهایی مانند MinIO (که به صورت On-Premise قابل پیادهسازی است) یا سرویسهای ابری، جایگزین بسیار مقیاسپذیر و ارزانتری برای HDFS هستند. این سیستمها از تکنیک Erasure Coding به جای Replication استفاده میکنند که فضای بسیار کمتری مصرف میکند.

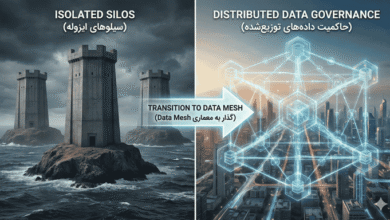

دسته سوم: رویکردهای معماری و عملیاتی (Architectural & Operational Approaches)

-

جداسازی پردازش از ذخیرهسازی (Decoupling Compute and Storage):

در معماریهای مدرن، به جای نگهداری داده و پردازش روی یک کلاستر (مانند مدل سنتی Hadoop)، پردازش (مثلاً با Spark) به صورت موقت و بر اساس نیاز اجرا میشود و دادهها روی یک لایه ذخیرهسازی ارزان (مانند Object Storage) نگهداری میشوند. این معماری به شما اجازه میدهد منابع پردازشی را فقط در زمان نیاز روشن و پس از اتمام کار خاموش کنید و در هزینهها به شدت صرفهجویی کنید. -

استفاده از زیرساخت ترکیبی (Hybrid Infrastructure):

دادههای “داغ” و حساس را روی زیرساخت داخلی (On-Premise) نگهداری کنید و دادههای “سرد” و آرشیوی را به ارائهدهندگان خدمات ابری داخلی منتقل کنید که معمولاً هزینههای ذخیرهسازی کمتری دارند. -

پایش و تحلیل هزینهها (Monitoring & Cost Analysis):

ابزارهایی را برای پایش میزان مصرف فضای ذخیرهسازی توسط تیمها و پروژههای مختلف پیادهسازی کنید. با شناسایی پرمصرفترین بخشها، میتوانید تلاشهای بهینهسازی را متمرکز کنید.

نقشه راه عملی برای پیادهسازی

-

فاز ۱: ممیزی و تحلیل (Audit & Analysis – ۱ تا ۲ ماه):

- دادههای موجود را شناسایی و دستهبندی کنید.

- الگوهای دسترسی به دادهها را تحلیل کنید (کدام دادهها داغ، گرم یا سرد هستند؟).

- هزینههای فعلی ذخیرهسازی را به تفکیک محاسبه کنید.

-

فاز ۲: اقدامات سریع و کمهزینه (Quick Wins – ۲ تا ۴ ماه):

- فشردهسازی را روی دادههای حجیم فعال کنید.

- دادههای موقت و لاگهای غیرضروری قدیمی را حذف کنید.

- فرمت دادههای جدید را به Parquet یا ORC تغییر دهید.

-

فاز ۳: پیادهسازی راهکارهای اصلی (Core Implementation – ۶ تا ۱۲ ماه):

- یک سیاست چرخه عمر داده (ILM) تعریف و پیادهسازی کنید.

- یک لایه ذخیرهسازی سرد/آرشیوی (مثلاً با MinIO) راهاندازی کنید.

- دادههای قدیمی را به فرمت Parquet تبدیل کرده و به لایههای ارزانتر منتقل کنید.

-

فاز ۴: بهینهسازی و اتوماسیون (Optimization & Automation – مستمر):

- فرآیندهای ILM و حذف داده را خودکار کنید.

- به طور مداوم سیستم را برای شناسایی نقاط جدید برای بهینهسازی پایش کنید.

ملاحظات ویژه برای سازمانهای ایرانی

- اولویتبندی راهکارهای نرمافزاری: با توجه به هزینه بالای سختافزار، راهکارهای نرمافزاری مانند فشردهسازی، فرمتهای ستونی و Erasure Coding (در سیستمهایی مثل MinIO) بازگشت سرمایه بسیار بالاتری دارند.

- استفاده از راهکارهای متنباز (Open Source): ابزارهایی مانند Hadoop، MinIO، Spark و Ceph کاملاً متنباز هستند و هزینه لایسنس ندارند. تمرکز باید بر روی جذب یا آموزش نیروی متخصص برای کار با این ابزارها باشد.

- ابر داخلی (Private Cloud): راهاندازی یک زیرساخت Object Storage داخلی با ابزارهایی مانند MinIO میتواند جایگزین بسیار خوبی برای سرویسهای ابری خارجی (مانند Amazon S3) باشد و کنترل کامل بر دادهها و هزینهها را فراهم کند.

با اجرای این استراتژیها، سازمان شما میتواند بدون قربانی کردن قابلیتهای تحلیلی، هزینههای ذخیرهسازی کلانداده خود را به طور چشمگیری کاهش دهد.