مقدمه: عبور از مرز “بزرگ” به “عظیم”

در دنیای داده، همه دیتاستها “بزرگ” هستند، اما برخی از آنها در مقیاسی کاملاً متفاوت قرار دارند. وقتی از دیتاستهای گیگابایتی یا حتی ترابایتی صحبت میکنیم، بسیاری از ابزارهای سنتی و تک-ماشینی هنوز کارایی دارند. اما زمانی که وارد قلمرو پتابایت (Petabyte) یا اگزابایت (Exabyte) میشویم، قوانین بازی به کلی تغییر میکند. این مقیاس، که ما آن را “به شدت بزرگ” مینامیم، نیازمند یک تغییر پارادایم کامل در تفکر، معماری و ابزارهاست.

مدیریت این حجم از داده دیگر یک چالش ذخیرهسازی نیست؛ بلکه یک چالش مهندسی سیستمهای توزیعشده است. مهندسی داده در این مقیاس، هنر و علم طراحی، ساخت و نگهداری سیستمهایی است که میتوانند دادهها را به صورت قابل اعتماد، کارآمد و امن در سراسر چرخه عمرشان مدیریت کنند. این راهنما یک نقشه راه عملی برای تسلط بر این چالش است.

بخش اول: اصول بنیادین و تغییر ذهنیت

قبل از ورود به ابزارها، باید ذهنیت خود را با اصول حاکم بر اکوسیستمهای داده عظیم هماهنگ کنیم.

۱.۱. سیستمهای توزیعشده، انتخاب پیشفرض است

یک ماشین واحد، هر چقدر هم قدرتمند باشد، نمیتواند یک پتابایت داده را در حافظه خود جای دهد یا در زمان معقول پردازش کند. بنابراین، تمام عملیاتها باید بر روی یک کلاستر (Cluster) از ماشینها انجام شود. این یعنی:

- دادهها توزیع میشوند: فایلها به قطعات کوچکتر (Blocks) تقسیم شده و بر روی چندین ماشین ذخیره میشوند.

- پردازش توزیع میشود: محاسبات به صورت موازی بر روی بخشهای مختلف داده در ماشینهای مختلف اجرا میشوند.

- تحمل خطا (Fault Tolerance) حیاتی است: در کلاستری با هزاران ماشین، خرابی یک یا چند ماشین یک اتفاق روزمره است، نه یک فاجعه. سیستم باید طوری طراحی شود که با این خرابیها به صورت خودکار مقابله کند.

۱.۲. محاسبات را به سمت داده ببرید، نه داده را به سمت محاسبات

انتقال پتابایتها داده از طریق شبکه، کند، پرهزینه و اغلب غیرممکن است. اصل کلیدی این است که کد یا منطق پردازشی خود را به ماشینهایی ارسال کنید که دادهها در آنجا قرار دارند. موتورهای پردازشی مدرن مانند Apache Spark ذاتاً بر این اساس کار میکنند.

۱.۳. اسکیما پادشاه است: Schema-on-Read در مقابل Schema-on-Write

- Schema-on-Write (روش سنتی): دادهها قبل از نوشته شدن در پایگاه داده، باید با یک اسکیمای از پیش تعریفشده مطابقت داشته باشند (مانند انبارهای داده). این روش ساختاریافته اما انعطافناپذیر است.

- Schema-on-Read (روش مدرن): دادههای خام با هر فرمتی در یک مخزن (مانند Data Lake) ذخیره میشوند و اسکیما تنها در زمان خواندن و پردازش دادهها به آنها اعمال میشود. این روش برای حجم و تنوع بالای دادههای عظیم، انعطافپذیری فوقالعادهای فراهم میکند.

۱.۴. اتوماسیون، یک الزام است نه یک گزینه

در مقیاس پتابایتی، مدیریت دستی خطوط لوله داده، استقرار زیرساخت یا پایش کیفیت غیرممکن است. همه چیز باید خودکار شود:

- زیرساخت به عنوان کد (Infrastructure as Code – IaC): استفاده از ابزارهایی مانند Terraform یا CloudFormation برای تعریف و مدیریت زیرساخت.

- ارکستراسیون جریان کار (Workflow Orchestration): استفاده از ابزارهایی مانند Apache Airflow یا Dagster برای تعریف، زمانبندی و پایش خطوط لوله داده.

- CI/CD برای داده: پیادهسازی خطوط لوله یکپارچهسازی و استقرار مداوم برای کد پردازشی و تستهای داده.

بخش دوم: معماری ذخیرهسازی در مقیاس عظیم

نحوه ذخیرهسازی دادهها، مهمترین تصمیمی است که بر عملکرد، هزینه و انعطافپذیری کل سیستم تأثیر میگذارد.

۲.۱. دریاچه داده (Data Lake): اقیانوس دادههای شما

دریاچه داده یک مخزن متمرکز است که به شما اجازه میدهد دادههای ساختاریافته و بدون ساختار را در هر مقیاس ذخیره کنید. معماری مدرن دریاچه داده بر پایه سرویسهای ذخیرهسازی اشیاء (Object Storage) ابری مانند Amazon S3, Google Cloud Storage (GCS) یا Azure Blob Storage بنا شده است. این سرویسها مزایای زیر را ارائه میدهند:

- مقیاسپذیری تقریباً نامحدود.

- هزینه بسیار پایین به ازای هر گیگابایت.

- دوام و دسترسپذیری بسیار بالا.

۲.۲. فرمتهای فایل: ستون فقرات عملکرد

انتخاب فرمت فایل، تأثیرگذارترین عامل بر سرعت کوئریها و هزینههای پردازش است. برای دیتاستهای عظیم، استفاده از فرمتهای ستونی (Columnar Formats) یک ضرورت است.

- چرا فرمتهای سنتی (CSV, JSON) ناکارآمد هستند؟ این فرمتها سطری هستند. برای خواندن تنها ۲ ستون از یک فایل با ۱۰۰ ستون، باید کل فایل را از دیسک بخوانید و پردازش کنید.

- Apache Parquet و Apache ORC: این دو فرمت، استاندارد طلایی در دنیای کلان داده هستند.

- ذخیرهسازی ستونی: دادهها را بر اساس ستون ذخیره میکنند. این امر به موتورهای پردازشی اجازه میدهد تنها ستونهای مورد نیاز برای یک کوئری را بخوانند (Column Pruning).

- فشردهسازی بسیار کارآمد: هر ستون به صورت جداگانه با الگوریتم مناسب فشرده میشود.

- پشتیبانی از Predicate Pushdown: فیلترهای کوئری (مانند

WHERE country = 'US') مستقیماً در لایه ذخیرهسازی اعمال میشوند و از خواندن دادههای غیرمرتبط جلوگیری میکنند.

۲.۳. پارتیشنبندی (Partitioning): هنر نادیده گرفتن دادهها

پارتیشنبندی، تکنیکی برای تقسیمبندی فیزیکی دادهها در پوشههای مجزا بر اساس مقادیر یک یا چند ستون است. این کار به موتورهای کوئری اجازه میدهد تا به جای اسکن کل دیتاست، فقط پوشههای مرتبط با کوئری را اسکن کنند.

- مثال: یک دیتاست وقایع (Events) را بر اساس تاریخ پارتیشنبندی میکنیم. ساختار پوشهها به این شکل خواهد بود:

s3://my-datalake/events/year=2024/month=05/day=26/... s3://my-datalake/events/year=2024/month=05/day=27/...یک کوئری که فقط به دادههای روز ۲۷ می نیاز دارد، به طور کامل تمام پوشههای دیگر را نادیده میگیرد و سرعت را به شدت افزایش میدهد.

۲.۴. فرمتهای جدول (Table Formats): نسل جدید دریاچه داده

دریاچههای داده سنتی با مشکلاتی مانند عدم پشتیبانی از تراکنشهای ACID، بهروزرسانی سخت دادهها و عدم سازگاری بین موتورهای مختلف مواجه بودند. فرمتهای جدول مانند Apache Iceberg, Delta Lake و Apache Hudi این مشکلات را حل میکنند.

- تراکنشهای ACID: امکان انجام عملیاتهای خواندن و نوشتن همزمان به صورت ایمن.

- سفر در زمان (Time Travel): امکان کوئری زدن به نسخههای قبلی دادهها.

- تکامل اسکیما (Schema Evolution): امکان افزودن، حذف یا تغییر نام ستونها بدون نیاز به بازنویسی کل دیتاست.

این فرمتها، قابلیتهای یک انبار داده را به دریاچه داده میآورند و معماری Data Lakehouse را ممکن میسازند.

بخش سوم: پردازش و تبدیل داده در مقیاس پتابایت

پس از ذخیرهسازی، نوبت به پردازش و استخراج ارزش از دادهها میرسد.

۳.۱. موتورهای پردازش توزیعشده

- Apache Spark: استاندارد دوفاکتو برای پردازش دستهای (Batch) و نیمهجریانی (Micro-batch) دادههای عظیم. Spark با معماری مبتنی بر حافظه (In-memory) و بهینهساز کوئری قدرتمند خود (Catalyst Optimizer)، عملکرد فوقالعادهای ارائه میدهد.

- Apache Flink: پادشاه پردازش جریانی (Streaming). Flink برای کاربردهایی که نیاز به تأخیر بسیار کم و پردازش رویداد به رویداد دارند (مانند تشخیص تقلب بلادرنگ) ایدهآل است.

۳.۲. الگوی ELT (Extract, Load, Transform)

در مقیاس عظیم، الگوی سنتی ETL جای خود را به ELT میدهد:

- Extract: دادهها از منابع مختلف استخراج میشوند.

- Load: دادههای خام مستقیماً و با حداقل تغییرات در دریاچه داده بارگذاری میشوند.

- Transform: با استفاده از قدرت موتورهای پردازشی مانند Spark، دادهها درون دریاچه داده تبدیل، پاکسازی و غنیسازی میشوند.

این الگو از مقیاسپذیری و هزینه پایین ذخیرهسازی در دریاچه داده بهره میبرد.

۳.۳. ارکستراسیون با Apache Airflow

یک خط لوله داده مدرن شامل دهها یا صدها مرحله است که وابستگیهای پیچیدهای به یکدیگر دارند. Apache Airflow به شما اجازه میدهد این جریانهای کاری را به صورت گراف جهتدار غیرمدور (DAG) تعریف، زمانبندی و پایش کنید. Airflow تضمین میکند که هر مرحله تنها پس از موفقیت مراحل پیشنیاز خود اجرا شود و در صورت بروز خطا، اطلاعرسانی و تلاش مجدد را مدیریت میکند.

بخش چهارم: ارائه و دسترسی به دادهها (Serving Layer)

دادههای پردازششده باید به روشی کارآمد در دسترس تحلیلگران، دانشمندان داده و برنامههای کاربردی قرار گیرند.

۴.۱. موتورهای کوئری تحلیلی (Analytical Query Engines)

این ابزارها به کاربران اجازه میدهند با استفاده از SQL، کوئریهای تحلیلی پیچیدهای را مستقیماً بر روی دادههای موجود در دریاچه داده اجرا کنند.

- Trino (PrestoDB): یک موتور کوئری توزیعشده و بسیار سریع که برای کوئریهای تعاملی (Interactive) و ad-hoc طراحی شده است.

- Apache Druid: یک پایگاه داده تحلیلی بلادرنگ که برای داشبوردها و کاربردهایی که نیاز به agregations سریع بر روی دادههای جریانی دارند، بهینه شده است.

۴.۲. انبار داده ابری (Cloud Data Warehouse)

برای کاربردهای هوش تجاری (BI) که نیاز به بالاترین سطح عملکرد و سادگی دارند، دادههای کلیدی و تجمیعشده از دریاچه داده به یک انبار داده ابری مانند Snowflake, Google BigQuery یا Amazon Redshift منتقل میشوند. این پلتفرمها، مدیریت زیرساخت را به طور کامل از دوش کاربر برداشته و عملکرد فوقالعادهای برای کوئریهای BI ارائه میدهند.

بخش پنجم: حاکمیت، امنیت و کیفیت

در مقیاس پتابایتی، حاکمیت داده از یک موضوع اداری به یک ضرورت فنی تبدیل میشود.

۵.۱. کاتالوگ داده و کشف (Data Catalog & Discovery)

با وجود هزاران دیتاست، چگونه کاربران میتوانند دادههای مورد نیاز خود را پیدا کنند؟ کاتالوگ داده (مانند Amundsen یا DataHub) به عنوان یک موتور جستجو برای دادهها عمل میکند. این ابزارها متادیتا (Metadata) را به صورت خودکار جمعآوری کرده و اطلاعاتی در مورد اسکیما، مالکیت، کیفیت و تبار داده (Data Lineage) ارائه میدهند.

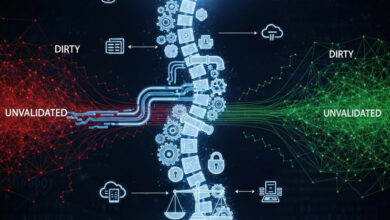

۵.۲. کنترل دسترسی و امنیت

- مدیریت هویت و دسترسی (IAM): استفاده از سرویسهای IAM ابری برای احراز هویت کاربران.

- کنترل دسترسی دانهریز: ابزارهایی مانند Apache Ranger به شما اجازه میدهند سیاستهای دسترسی را در سطح پایگاه داده، جدول، ستون و حتی ردیف تعریف کنید.

- رمزنگاری و پوشاندن داده: رمزنگاری دادهها در حالت سکون و در حال انتقال و استفاده از تکنیکهای پوشاندن داده (Data Masking) برای محافظت از اطلاعات حساس.

۵.۳. تضمین کیفیت داده

کیفیت پایین داده در مقیاس عظیم، منجر به فاجعه میشود.

- تست داده در خط لوله: ابزارهایی مانند Great Expectations یا تستهای داخلی dbt به شما اجازه میدهند assertions (تستها) را در مورد کیفیت دادهها (مانند عدم وجود مقدار null، توزیع مقادیر، و غیره) تعریف کرده و در هر مرحله از خط لوله داده اجرا کنید. اگر دادهها تستها را پاس نکنند، خط لوله متوقف میشود.

نتیجهگیری: مهندسی برای آینده

مدیریت دیتاستهای به شدت بزرگ یک سفر مهندسی پیچیده است که نیازمند ترکیبی از اصول معماری صحیح، انتخاب ابزار مناسب و اتوماسیون بیوقفه است. کلید موفقیت، پذیرش ماهیت توزیعشده این چالش و ساختن سیستمی است که نه تنها نیازهای امروز را برآورده میکند، بلکه برای رشد داده در آینده نیز مقیاسپذیر باشد. با تمرکز بر یک پایه محکم از ذخیرهسازی بهینه، پردازش کارآمد و حاکمیت قوی، سازمانها میتوانند از اقیانوس دادههای خود، بینشهای ارزشمندی را صید کرده و مزیت رقابتی پایداری را ایجاد کنند.