مقدمه: فراتر از فرم ورودی، به سوی خطوط لوله داده (Data Pipelines)

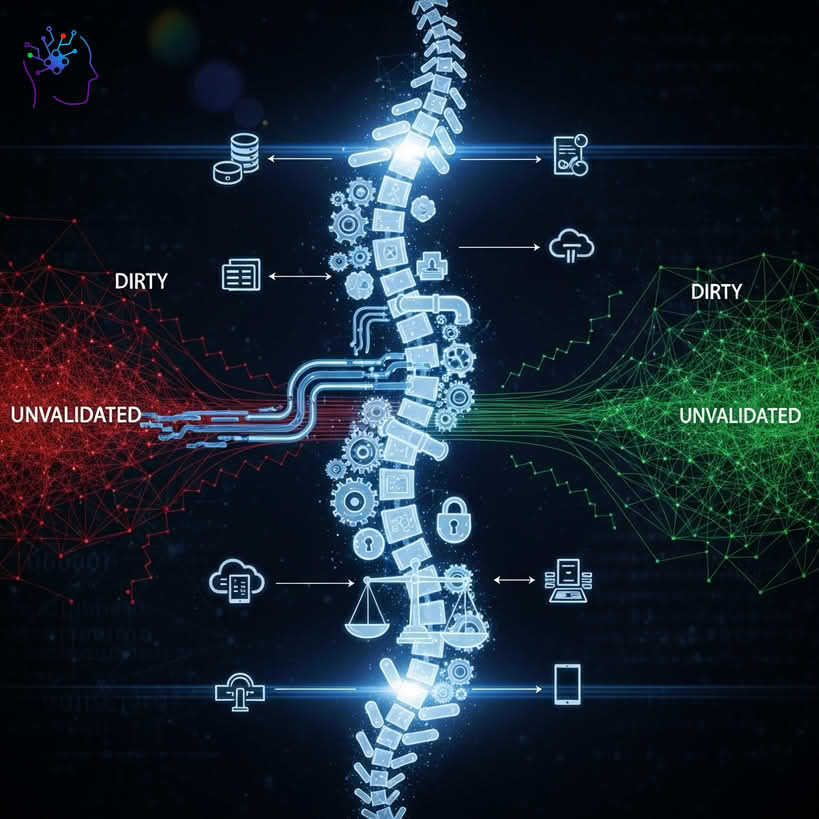

در مهندسی نرمافزار سنتی، اعتبارسنجی داده اغلب با تصویر یک فرم ثبتنام و پیغام خطای “ایمیل نامعتبر است” گره خورده است. این دیدگاه، اگرچه ضروری است، اما تنها نوک کوه یخ در یک سازمان دادهمحور (Data-Driven) مدرن است. برای یک مهندس داده، اعتبارسنجی داده یک مفهوم بسیار گستردهتر و عمیقتر است؛ این فرآیند، سیستم ایمنی کل اکوسیستم داده سازمان است که از دادهها در هر مرحله از چرخه حیاتشان محافظت میکند: از لحظه ورود (Ingestion) از منابع ناهمگون، در حین پردازش و تبدیل (Transformation) در خطوط لوله پیچیده، تا زمان بارگذاری (Loading) در انبارهای داده و دریاچههای داده، و حتی پس از آن، در حالت سکون (At Rest).

اصل “Garbage In, Garbage Out” (GIGO) در مقیاس سازمانی به “Garbage In, Garbage Warehouse, Garbage Analytics” تبدیل میشود. یک رکورد داده نامعتبر میتواند مانند یک ویروس عمل کند: یک خط لوله ETL/ELT را از کار بیندازد، یک گزارش تحلیلی را بیاعتبار سازد، یک مدل یادگیری ماشین را به خطا بیندازد و در نهایت، منجر به تصمیمات تجاری میلیاردها تومانی بر پایه اطلاعات غلط شود.

این مقاله، با عدسی مهندسی داده، به تشریح استراتژیها، معماریها و ابزارهای لازم برای ساخت یک سیستم اعتبارسنجی داده مستحکم و مقیاسپذیر میپردازد. ما از “چرا”ی استراتژیک فراتر رفته و به “کجا”، “چه چیزی” و “چگونه”ی پیادهسازی این فرآیند حیاتی در زیرساختهای داده مدرن خواهیم پرداخت.

فصل اول: اهمیت استراتژیک اعتبارسنجی داده در سازمان

از منظر مهندسی داده، اعتبارسنجی صرفاً یک الزام فنی نیست، بلکه یک توانمندساز استراتژیک است که بر پنج حوزه کلیدی تأثیر میگذارد:

۱. زیربنای تحلیل قابل اعتماد و هوش تجاری (BI)

داشبوردهای مدیریتی، گزارشهای فصلی و تحلیلهای کسبوکار تنها به اندازه دادههای ورودیشان ارزش دارند. اعتبارسنجی تضمین میکند که معیارهای کلیدی عملکرد (KPIs) بر اساس دادههای کامل، دقیق و سازگار محاسبه میشوند. بدون آن، مدیران ممکن است بر اساس روندهای کاذب یا مقادیر پرت (Outliers) ناشی از خطای داده، تصمیمات اشتباه بگیرند.

۲. سلامت و دقت مدلهای یادگیری ماشین (Machine Learning)

مدلهای ML به شدت به کیفیت دادههای آموزشی حساس هستند. دادههای نامعتبر، ناقص یا دارای توزیع آماری نامناسب میتوانند منجر به بایاس (Bias)، عملکرد ضعیف (Poor Performance) و رانش مدل (Model Drift) شوند. اعتبارسنجی داده در خطوط لوله MLOps، اولین و مهمترین گام برای اطمینان از آموزش مدلها با دادههای باکیفیت و حفظ عملکرد آنها در محیط عملیاتی است.

۳. پایداری و کارایی عملیاتی خطوط لوله داده

خطاهای داده، یکی از دلایل اصلی شکست خطوط لوله ETL/ELT هستند. یک تاریخ با فرمت اشتباه یا یک نوع داده ناسازگار میتواند یک Job پردازش داده با حجم ترابایتی را متوقف کند. این امر نه تنها نیازمند مداخله دستی و صرف زمان مهندسان گرانقیمت است، بلکه باعث تأخیر در تحویل دادههای حیاتی به ذینفعان میشود. یک سیستم اعتبارسنجی پیشگیرانه، این شکستها را قبل از وقوع شناسایی و مدیریت میکند.

۴. حاکمیت داده (Data Governance) و انطباق با مقررات (Compliance)

در عصر مقرراتی مانند GDPR، CCPA و قوانین محلی حفاظت از داده، سازمانها موظف به حفظ دقت و یکپارچگی دادههای مشتریان هستند. اعتبارسنجی داده، ابزاری حیاتی برای اجرای سیاستهای حاکمیت داده است و به اثبات انطباق با این مقررات کمک میکند. این فرآیند تضمین میکند که دادهها مطابق با تعاریف موجود در کاتالوگ داده (Data Catalog) سازمان هستند.

۵. ایجاد فرهنگ اعتماد به داده (Trust in Data)

مهمترین دارایی یک تیم داده، اعتمادی است که تحلیلگران، دانشمندان داده و مدیران کسبوکار به دادههای ارائه شده توسط آنها دارند. اگر ذینفعان به طور مداوم با دادههای متناقض یا نادرست مواجه شوند، به تدریج اعتماد خود را به کل پلتفرم داده از دست میدهند و به روشهای سنتی و مبتنی بر شهود بازمیگردند. اعتبارسنجی، سنگ بنای ایجاد و حفظ این اعتماد است.

فصل دوم: نقاط اعتبارسنجی در چرخه حیات داده (The “Where”)

اعتبارسنجی نباید یک رویداد منفرد باشد، بلکه یک فرآیند مستمر در سراسر خط لوله داده است. چهار نقطه کنترلی حیاتی برای اعتبارسنجی وجود دارد:

۱. در نقطه ورود (At Ingestion)

این اولین و مهمترین خط دفاعی است. دادهها از منابع مختلفی وارد اکوسیستم میشوند: پایگاههای داده عملیاتی (OLTP)، APIهای سرویسهای ثالث، فایلهای CSV/JSON آپلود شده توسط کاربران، یا جریانهای داده آنی (Streaming Data) از Kafka. در این مرحله، اعتبارسنجی بر موارد زیر تمرکز دارد:

- اعتبارسنجی اسکیمای اولیه (Schema Validation): آیا ساختار داده (نام ستونها، نوع دادهها) با آنچه انتظار میرود مطابقت دارد؟

- بررسی فرمت و نوع داده: آیا تاریخها، اعداد و رشتهها فرمت صحیحی دارند؟

- بررسی کامل بودن (Completeness): آیا فیلدهای ضروری وجود دارند؟

۲. در حین تبدیل (During Transformation)

پس از ورود دادهها به دریاچه داده (Data Lake) یا یک لایه میانی (Staging Area)، فرآیندهای تبدیل (مانند Spark Jobs یا مدلهای dbt) بر روی آنها اجرا میشوند. اعتبارسنجی در این مرحله پیچیدهتر و متمرکز بر منطق کسبوکار است:

- بررسی یکپارچگی ارجاعی (Referential Integrity): آیا

user_idدر جدول سفارشها، در جدول کاربران وجود دارد؟ - اعتبارسنجی قوانین کسبوکار: آیا قیمت یک محصول منفی است؟ آیا تاریخ تحویل قبل از تاریخ سفارش است؟

- بررسی سازگاری بین رکوردی (Inter-record Consistency): آیا مجموع مبالغ اقلام یک فاکتور با مبلغ کل فاکتور برابر است؟

۳. قبل از بارگذاری در انبار داده (Pre-Load to Warehouse)

این آخرین نقطه کنترل قبل از ارائه دادهها به مصرفکنندگان نهایی است. دادهها در این مرحله باید پاک، یکپارچه و آماده تحلیل باشند. اعتبارسنجی در اینجا تضمین میکند که:

- اسکیمای نهایی انبار داده (مانند Snowflake, BigQuery) رعایت شده است.

- هیچ مقدار Null در ستونهایی که نباید خالی باشند، وجود ندارد.

- رکوردهای تکراری (Duplicate Records) حذف شدهاند.

۴. در حالت سکون (At Rest Monitoring)

کیفیت داده ثابت نیست و میتواند به مرور زمان تخریب شود. “رانش داده” (Data Drift) زمانی رخ میدهد که ویژگیهای آماری دادهها تغییر میکند. اعتبارسنجی در حالت سکون یک فرآیند نظارتی است:

- پروفایلسازی داده (Data Profiling): اجرای دورهای کوئریها برای نظارت بر آمار کلیدی دادهها (مانند میانگین، میانه، درصد مقادیر Null، تعداد مقادیر یکتا).

- تشخیص ناهنجاری (Anomaly Detection): آیا حجم دادههای ورودی امروز به طور ناگهانی نصف شده است؟ آیا توزیع مقادیر یک ستون به طور غیرمنتظرهای تغییر کرده است؟

فصل سوم: طبقهبندی قوانین اعتبارسنجی (The “What”)

قوانین اعتبارسنجی را میتوان در یک طیف، از ساده به پیچیده، دستهبندی کرد:

-

اعتبارسنجیهای سطح فیلد (Field-Level):

- نوع داده (Data Type): Integer, String, Timestamp, Boolean

- فرمت (Format): استفاده از عبارات باقاعده (Regex) برای ایمیل، کد ملی، شماره تلفن.

- محدوده (Range): مقادیر عددی باید بین یک حداقل و حداکثر باشند.

- طول (Length): طول رشته باید در محدوده مجاز باشد.

- مجموعه مقادیر مجاز (Set Membership): مقدار باید یکی از اعضای یک لیست از پیشتعریفشده باشد (مانند وضعیت سفارش:

CREATED,SHIPPED,DELIVERED). - کامل بودن (Completeness): بررسی

NOT NULL.

-

اعتبارسنجیهای سطح رکورد (Record-Level / Cross-Field):

- سازگاری شرطی: اگر

countryبرابرUSAاست، فیلدstateنمیتواند Null باشد. - سازگاری منطقی:

end_dateباید بزرگتر یا مساویstart_dateباشد.

- سازگاری شرطی: اگر

-

اعتبارسنجیهای سطح مجموعه داده (Dataset-Level / Cross-Record):

- یکتایی (Uniqueness): یک ستون (یا ترکیبی از ستونها) نباید مقادیر تکراری داشته باشد (مانند کلید اصلی).

- یکپارچگی ارجاعی (Referential Integrity): مقادیر یک ستون (کلید خارجی) باید در ستون دیگری (کلید اصلی) وجود داشته باشند.

-

اعتبارسنجیهای آماری و توزیعی (Statistical & Distributional):

- بررسی مقادیر پرت (Outlier Detection): آیا مقداری به طور قابل توجهی از میانگین یا میانه فاصله دارد؟

- توزیع (Distribution): آیا توزیع دادهها با توزیع مورد انتظار (مثلاً توزیع نرمال) مطابقت دارد؟

- حجم داده (Freshness & Volume): آیا تعداد رکوردهای دریافتی در بازه زمانی مشخص در محدوده مورد انتظار است؟ آیا دادهها به موقع (Fresh) هستند؟

فصل چهارم: معماری و بهترین شیوههای پیادهسازی (The “How”)

پیادهسازی یک سیستم اعتبارسنجی موثر نیازمند یک رویکرد معماری فکرشده است.

۱. رویکرد اعلامی (Declarative) به جای دستوری (Imperative)

به جای نوشتن کدهای پیچیده و سفارشی برای هر قانون (رویکرد دستوری)، از ابزارهایی استفاده کنید که به شما اجازه میدهند قوانین را به صورت اعلامی تعریف کنید. شما “چه چیزی” باید معتبر باشد را تعریف میکنید، نه “چگونه” باید بررسی شود. این رویکرد خوانایی، نگهداری و استفاده مجدد از قوانین را به شدت بهبود میبخشد.

- مثال: به جای نوشتن یک تابع پایتون برای بررسی یکتایی یک ستون، در ابزاری مانند dbt به سادگی یک تست

uniqueبرای آن ستون تعریف میکنید.

۲. قراردادهای داده (Data Contracts)

قرارداد داده یک توافقنامه رسمی و قابل اجرا بین تولیدکنندگان داده (مانند تیم سرویسهای Backend) و مصرفکنندگان داده (تیم داده) است. این قرارداد اسکیمای داده، معانی семанتیکی، انتظارات کیفی (مانند درصد Null مجاز) و SLAهای مربوط به تازگی داده را مشخص میکند. اعتبارسنجی در نقطه ورود، در واقع اجرای این قرارداد است. این رویکرد، مسئولیت کیفیت داده را به سمت چپ، یعنی به سمت تولیدکننده، منتقل میکند (Shift-Left on Data Quality).

۳. استراتژی مدیریت دادههای نامعتبر (Quarantine Strategy)

وقتی یک رکورد نامعتبر شناسایی میشود، چه باید کرد؟

- رد کردن (Reject): رکورد به طور کامل حذف میشود. این روش برای دادههای غیرحیاتی مناسب است اما میتواند منجر به از دست رفتن اطلاعات شود.

- قرنطینه کردن (Quarantine): رکوردهای نامعتبر به یک “صف انتظار” یا جدول جداگانه (Dead-Letter Queue) منتقل میشوند تا بعداً به صورت دستی یا خودکار بررسی و اصلاح شوند. این رویکرد، بهترین توازن بین حفظ یکپارچگی و جلوگیری از از دست رفتن داده است.

- متوقف کردن خط لوله (Fail Pipeline): برای خطاهای حیاتی (مانند شکست اسکیمای اصلی)، کل خط لوله باید متوقف شده و یک هشدار فوری ارسال شود.

۴. مرکزیتبخشی به قوانین اعتبارسنجی (Centralized Rule Engine)

قوانین کسبوکار را در کد خطوط لوله داده خود هاردکد نکنید. از یک مخزن مرکزی برای مدیریت قوانین استفاده کنید. این مخزن میتواند یک فایل YAML ساده، یک پایگاه داده، یا یک ابزار تخصصی حاکمیت داده باشد. این کار به تحلیلگران کسبوکار اجازه میدهد تا بدون نیاز به تغییر کد، قوانین را مشاهده و حتی ویرایش کنند.

۵. خودکارسازی و یکپارچهسازی با DataOps

تستهای اعتبارسنجی داده باید بخشی جداییناپذیر از فرآیند CI/CD شما برای داده باشند (که به آن DataOps میگویند). هر تغییری در کد تبدیل داده باید به طور خودکار تستهای کیفیت داده مربوطه را روی یک مجموعه داده نمونه اجرا کند، قبل از اینکه در محیط عملیاتی مستقر شود.

فصل پنجم: ابزارهای کلیدی در جعبه ابزار مهندس داده

اکوسیستم ابزارهای کیفیت و اعتبارسنجی داده به سرعت در حال رشد است:

-

ابزارهای تبدیل داده با قابلیت تست داخلی:

- dbt (Data Build Tool): این ابزار، انقلابی در اعتبارسنجی درون انبار داده ایجاد کرده است. با

dbt testsمیتوانید به راحتی قوانینی مانندunique,not_null,relationships(برای یکپارچگی ارجاعی) و تستهای سفارشی مبتنی بر SQL را تعریف و اجرا کنید.

- dbt (Data Build Tool): این ابزار، انقلابی در اعتبارسنجی درون انبار داده ایجاد کرده است. با

-

فریمورکهای تخصصی کیفیت داده:

- Great Expectations (GE): استاندارد طلایی در این حوزه است. GE به شما امکان میدهد “انتظارات” (Expectations) را به صورت اعلامی و به زبان ساده تعریف کنید، دادههای خود را در برابر آنها اعتبارسنجی کنید و به طور خودکار “مستندات کیفیت داده” (Data Docs) تولید نمایید. این ابزار برای اعتبارسنجی در تمام نقاط خط لوله مناسب است.

- Soda Core: یک ابزار متنباز دیگر که با استفاده از زبان SodaCL (یک DSL مبتنی بر YAML) امکان تعریف و اجرای بررسیهای کیفیت داده را فراهم میکند.

-

کتابخانههای پردازش داده:

- Apache Spark: با استفاده از DataFrame API و توابع سفارشی (UDFs)، میتوانید منطقهای اعتبارسنجی پیچیدهای را برای پردازش دادههای حجیم پیادهسازی کنید.

- Pandas (با کتابخانههایی مانند Pandera): برای اعتبارسنجی داده در مقیاس کوچکتر یا در مراحل اولیه توسعه و تحلیل داده، Pandera یک اسکیمای اعتبارسنجی قدرتمند برای DataFrameهای Pandas ارائه میدهد.

-

پلتفرمهای مشاهدهپذیری داده (Data Observability):

- ابزارهای تجاری مانند Monte Carlo, Bigeye, و Anomalo یک لایه بالاتر از اعتبارسنجی سنتی قرار میگیرند. آنها با استفاده از یادگیری ماشین، به طور خودکار دادههای شما را پروفایل کرده و ناهنجاریها را در حجم، تازگی، توزیع و اسکیمای داده تشخیص میدهند، بدون اینکه نیاز به تعریف دستی تمام قوانین باشد.

نتیجهگیری: اعتبارسنجی به مثابه یک فرهنگ، نه یک پروژه

از دیدگاه مهندسی داده، اعتبارسنجی داده یک پروژه با نقطه شروع و پایان نیست؛ بلکه یک فرآیند مستمر و یک فرهنگ است که باید در سراسر سازمان نهادینه شود. این فرهنگ با پذیرش این اصل آغاز میشود که کیفیت داده، مسئولیت همگانی است، از توسعهدهنده نرمافزار که داده را تولید میکند تا تحلیلگری که آن را مصرف مینماید.

نقش مهندس داده در این میان، ساختن زیرساختها، خطوط لوله و ابزارهای خودکاری است که این فرهنگ را توانمند میسازد. با پیادهسازی یک استراتژی اعتبارسنجی چندلایه، استفاده از ابزارهای اعلامی، و ترویج مفهوم قراردادهای داده، میتوانیم اکوسیستمهای دادهای بسازیم که نه تنها قدرتمند و مقیاسپذیر، بلکه به طور بنیادین قابل اعتماد باشند. در نهایت، این اعتماد است که به سازمان اجازه میدهد تا با اطمینان کامل، از بزرگترین دارایی خود یعنی دادهها، برای نوآوری و رشد استفاده کند.