چکیده اجرایی

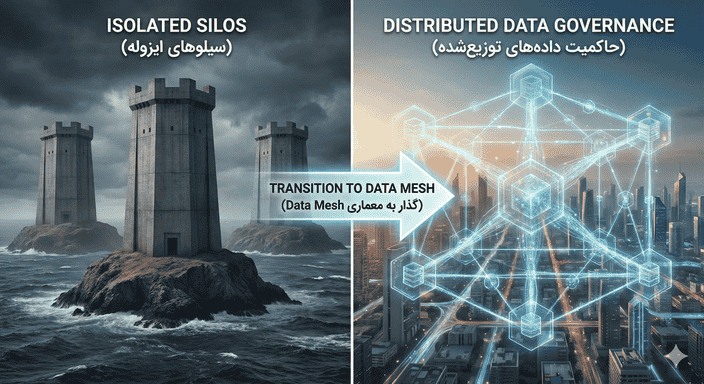

در دنیای دیجیتال امروز، دادهها دیگر تنها یک محصول جانبی از فرآیندهای کسبوکار نیستند، بلکه خودِ دارایی اصلی محسوب میشوند. با این حال، معماریهای سنتی مدیریت داده مانند Data Warehouse (انبار داده) و Data Lake (دریاچه داده) در مقیاسهای بزرگ با شکست مواجه شدهاند. گلوگاههای مرکزی، کیفیت پایین دادهها و فاصله زیاد بین تولیدکنندگان و مصرفکنندگان داده، سازمانها را فلج کرده است. Data Mesh (دیتا مش) یک تغییر پارادایم اجتماعی-تکنیکال (Socio-technical) است که توسط ژامک دهقانی (Zhamak Dehghani) معرفی شد. این رویکرد به جای تمرکز بر یک پلتفرم یکپارچه مرکزی، بر تمرکززدایی و توزیع مالکیت دادهها بین تیمهای دامنهمحور (Domain-oriented) تاکید دارد. این مقاله به بررسی عمیق اصول چهارگانه دیتا مش، معماری فنی، چالشهای پیادهسازی و مقایسه آن با سایر معماریها میپردازد.

۱. مقدمه: بحران معماریهای یکپارچه (Monolithic)

برای دههها، رویای سازمانهای بزرگ ایجاد یک «منبع حقیقت واحد» (Single Source of Truth) بود. استراتژی این بود: تمام دادهها را از سیستمهای عملیاتی مختلف جمعآوری کنید، آنها را تمیز کنید و در یک مخزن مرکزی بزرگ بریزید تا تحلیلگران بتوانند از آن استفاده کنند.

۱.۱. عصر انبار داده (Data Warehouse) – نسل اول

در دهه ۹۰ و اوایل ۲۰۰۰، انبارهای داده حکمرانی میکردند. فرآیند ETL (Extract, Transform, Load) دادهها را از منابع رابطهای استخراج کرده و به یک Schema از پیش تعریف شده (مانند Star Schema) منتقل میکرد.

-

مشکل: این مدل برای دادههای ساختاریافته عالی بود، اما در برابر حجم عظیم دادههای بدون ساختار و تغییرات سریع نیازمندیهای کسبوکار، بسیار خشک و غیرقابل انعطاف بود.

۱.۲. عصر دریاچه داده (Data Lake) – نسل دوم

با ظهور Big Data و Hadoop، پارادایم به سمت «اول ذخیره کن، بعداً ساختار بده» (ELT) تغییر کرد. دریاچههای داده وعده دادند که میتوانند هر نوع دادهای را ذخیره کنند.

-

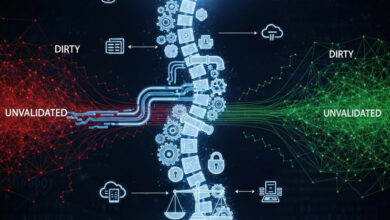

مشکل: دریاچههای داده به سرعت به باتلاق داده (Data Swamp) تبدیل شدند. حجم عظیمی از دادهها بدون مستندات، بدون مالک مشخص و با کیفیت پایین انباشته شد. تیمهای مهندسی داده مرکزی تبدیل به گلوگاه شدند؛ آنها باید دادههایی را مدیریت میکردند که معنای بیزینسی آن را درک نمیکردند.

۱.۳. بنبست تیمهای مرکزی

در هر دو نسل قبلی، یک پیشفرض ثابت وجود داشت: معماری یکپارچه (Monolithic) با تیم مرکزی.

یک تیم محدود از مهندسان داده (Hyper-specialized data engineers) مسئولیت دریافت داده از دهها دامنه (بازاریابی، فروش، لجستیک) و تحویل آن به دهها مصرفکننده را داشتند. این تیمها زیر بار درخواستها خرد میشدند، زیرا دانش دامنه (Domain Knowledge) نداشتند و صرفاً لولهکشهای داده (Data Plumbers) بودند.

اینجاست که Data Mesh به عنوان راه حلی برای شکستن این بنبست ظهور کرد.

۲. دیتا مش (Data Mesh) چیست؟

دیتا مش یک فناوری یا ابزار خاص نیست؛ بلکه یک رویکرد معماری و سازمانی است. دیتا مش فرض میکند که در سازمانهای بزرگ و پیچیده، متمرکز کردن دادهها محکوم به شکست است. در عوض، دیتا مش اصول معماری میکروسرویسها (Microservices) را به دنیای داده میآورد.

اگر میکروسرویسها اپلیکیشنهای یکپارچه را شکستند، دیتا مش دریاچههای داده یکپارچه را میشکند.

هسته اصلی دیتا مش بر این استدلال استوار است که داده باید توسط کسانی مدیریت شود که آن را بهتر از همه میشناسند: تیمهای دامنه (Domain Teams).

۳. اصول چهارگانه دیتا مش

ژامک دهقانی چهار اصل بنیادین را برای دیتا مش تعریف کرده است که ستونهای اصلی این معماری را تشکیل میدهند. درک عمیق این اصول برای پیادهسازی موفق حیاتی است.

اصل اول: مالکیت دامنهمحور (Domain-Oriented Ownership)

این اصل مستقیماً از طراحی دامنه-محور (DDD – Domain Driven Design) وام گرفته شده است. به جای اینکه دادهها بر اساس نوع فنی (مثلاً تمام فایلهای JSON در یک جا، تمام جداول SQL در جای دیگر) تقسیم شوند، باید بر اساس محدودههای کسبوکار (Bounded Contexts) تقسیم شوند.

-

تغییر ساختار: تیم بازاریابی نه تنها مسئول اپلیکیشنهای بازاریابی است، بلکه مسئول دادههای تحلیلی تولید شده توسط آن اپلیکیشنها نیز هست.

-

حذف گلوگاه: وقتی هر تیم مسئول دادههای خود است، تیم مرکزی مهندسی داده حذف میشود. تیم “پخش” مسئول دادههای مربوط به حملونقل است و تیم “فروش” مسئول دادههای سفارشات.

-

نزدیکی به منبع: چه کسی بهتر از تیم توسعهدهنده نرمافزار Checkout میداند که فیلد order_status چه معنایی دارد؟ هیچکس. پس آنها باید مالک آن باشند.

اصل دوم: داده به عنوان محصول (Data as a Product)

یکی از بزرگترین مشکلات دریاچههای داده این بود که دادهها صرفاً به عنوان “محصول جانبی” یا “دارایی” (Asset) دیده میشدند. در دیتا مش، داده یک محصول است و تیمهای دامنه، صاحبان این محصول هستند. سایر تیمها (تحلیلگران، دانشمندان داده) مشتریان این محصول هستند.

برای اینکه داده یک محصول باشد، باید ویژگیهای زیر را داشته باشد (D.A.T.S.I.S):

-

قابل کشف (Discoverable): باید در یک کاتالوگ مرکزی قابل جستجو باشد.

-

قابل آدرسدهی (Addressable): باید یک آدرس یکتا برای دسترسی داشته باشد.

-

قابل اعتماد (Trustworthy): دارای SLA و SLO مشخص برای کیفیت و تازگی باشد.

-

دارای مستندات خودکار (Self-describing): دارای متادیتای کامل و نمونه کد باشد.

-

قابل تعامل (Interoperable): از استانداردهای باز برای ادغام با سایر دادهها استفاده کند.

-

امن (Secure): سیاستهای دسترسی به طور پیشفرض روی آن اعمال شده باشد.

در این مدل، یک نقش جدید به نام Data Product Owner (مالک محصول داده) در تیمهای دامنه ایجاد میشود که مسئول رضایت مصرفکنندگان داده است.

اصل سوم: زیرساخت داده سلفسرویس به عنوان پلتفرم (Self-Serve Data Infrastructure as a Platform)

اگر از هر تیم دامنه بخواهیم که استک فنی دادههای خود را از صفر بسازد (موتور پردازش، فضای ذخیرهسازی، ابزار کاتالوگ و…)، هزینههای سربار و پیچیدگی فنی سرسامآور خواهد شد. اکثر تیمهای دامنه تخصص مهندسی داده عمیق ندارند.

-

راه حل: یک تیم پلتفرم مرکزی وجود دارد، اما کار آنها ساختن پایپلاین (Pipeline) نیست. کار آنها ساختن ابزارها و زیرساختهایی است که تیمهای دامنه بتوانند به صورت “سلفسرویس” از آنها استفاده کنند.

-

کاهش بار شناختی: پلتفرم باید پیچیدگیهای فنی (مانند تنظیمات Spark، مدیریت IAM در AWS، پیکربندی Kafka) را انتزاع (Abstract) کند.

-

مثال: یک تیم دامنه باید بتواند با یک دستور ساده یا یک فایل کانفیگ (Declarative)، یک فضای ذخیرهسازی امن و یک پایپلاین پردازش داده را بالا بیاورد، بدون اینکه درگیر جزئیات زیرساختی شود.

اصل چهارم: حاکمیت محاسباتی فدرال (Federated Computational Governance)

وقتی دادهها توزیع میشوند، بزرگترین خطر، ایجاد “سیلوهای داده” ناسازگار است. اگر تیم الف از شناسه مشتری UUID استفاده کند و تیم ب از Email، ادغام این دادهها غیرممکن میشود.

-

مدل فدرال: حاکمیت داده دیگر یک دیکتاتوری مرکزی نیست. بلکه یک فدراسیون متشکل از نمایندگان دامنههای مختلف و تیم پلتفرم است.

-

استانداردسازی: این گروه روی استانداردهای جهانی (Global Standards) توافق میکنند (مانند فرمت تاریخ، نحوه شناسایی موجودیتهای اصلی مثل مشتری، استانداردهای امنیتی). اما تصمیمات محلی (Local Decisions) به دامنهها واگذار میشود.

-

اجرای خودکار (Computational): سیاستها نباید در فایلهای PDF و مستندات اداری خاک بخورند. آنها باید به صورت کد (Policy as Code) در پلتفرم تعبیه شوند. مثلاً، پلتفرم به صورت خودکار اجازه نمیدهد دادهای بدون تگگذاری حساسیت (PII) منتشر شود.

۴. معماری فنی دیتا مش: کالبدشکافی یک نود (Node)

در معماری دیتا مش، واحد سازنده اصلی Data Quantum (کوانتوم داده) یا همان محصول داده است. این یک واحد معماری مستقل است که شامل موارد زیر است:

-

کد (Code): کدهای تبدیل داده (Transformation)، کدهای کیفیت داده و کدهای دسترسی.

-

داده (Data): دادههای پلیگلات (Polyglot) شامل جداول، فایلها، رویدادها.

-

متادیتا (Metadata): اطلاعات مربوط به ساختار، مالکیت و کیفیت.

-

زیرساخت (Infrastructure): منابع محاسباتی و ذخیرهسازی که به این محصول اختصاص یافته است.

پورتهای ورودی و خروجی (Ports)

هر محصول داده مانند یک میکروسرویس دارای واسطهایی است:

-

پورتهای ورودی (Input Ports): دریافت داده از سیستمهای عملیاتی یا سایر محصولات داده.

-

پورتهای خروجی (Output Ports): ارائه دادههای پردازش شده به مصرفکنندگان در قالبهای مختلف (SQL Interface, REST API, Parquet Files on S3, Kafka Topics).

-

پورتهای کنترلی (Control Ports): برای نظارت، لاگگیری و اعمال سیاستهای حاکمیتی توسط پلتفرم مرکزی.

۵. مقایسه دیتا مش با سایر معماریها

برای درک بهتر جایگاه دیتا مش، مقایسهای عمیق با رویکردهای مدرن دیگر ضروری است.

۵.۱. دیتا مش در برابر دیتا فابریک (Data Fabric)

این دو مفهوم اغلب با هم اشتباه گرفته میشوند، اما تفاوت فلسفی عمیقی دارند:

| ویژگی | Data Mesh | Data Fabric |

| رویکرد اصلی | مردم و فرآیند (سازمانی) | تکنولوژی و اتوماسیون (فنی) |

| مدل حاکمیت | توزیع شده (فدرال) | متمرکز (با ابزار هوشمند) |

| مالکیت داده | تیمهای دامنه | مجازیسازی شده توسط لایه فابریک |

| فلسفه | دادهها را در دامنهها مدیریت کنید | دادهها را با یک لایه مجازی یکپارچه کنید |

| نقش هوش مصنوعی | کمتر (تمرکز بر طراحی صریح) | زیاد (برای کشف خودکار متادیتا و روابط) |

دیتا فابریک سعی دارد پیچیدگی سیستمهای مختلف را با یک لایه تکنولوژیک هوشمند بپوشاند، در حالی که دیتا مش سعی دارد ساختار سازمانی را تغییر دهد تا پیچیدگی مدیریت شود. این دو میتوانند مکمل هم باشند؛ مثلاً میتوان از ابزارهای دیتا فابریک برای پیادهسازی پلتفرم سلفسرویس در دیتا مش استفاده کرد.

۵.۲. دیتا مش در برابر لیکهوس (Data Lakehouse)

لیکهوس (مانند Databricks یا Snowflake) یک معماری تکنولوژیک است که مزایای انبار داده (ACID transactions) را با دریاچه داده (Low cost storage) ترکیب میکند.

-

رابطه: لیکهوس میتواند به عنوان زیرساخت تکنولوژیک در یک نود (Node) دیتا مش استفاده شود.

-

تفاوت: لیکهوس به تنهایی مشکل سازمانی (تیم مرکزی گلوگاه شده) را حل نمیکند. شما میتوانید یک لیکهوس یکپارچه (Monolithic Lakehouse) داشته باشید که همچنان تمام مشکلات سازمانی قبل را دارد. دیتا مش میگوید: “بیایید چندین لیکهوس کوچک داشته باشیم که هر کدام متعلق به یک دامنه است و با هم تعامل دارند.”

۶. پیادهسازی دیتا مش: استراتژی و نقشه راه

پیادهسازی دیتا مش یک پروژه “Big Bang” نیست. این یک سفر تکاملی است که نیازمند تغییر فرهنگ سازمانی است.

فاز ۱: ارزیابی بلوغ و آمادگی

دیتا مش برای همه مناسب نیست. پیشنیازهای زیر حیاتی هستند:

-

تعداد زیاد دامنههای کسبوکار.

-

تیم مهندسی دادهای که تبدیل به گلوگاه شده است.

-

فرهنگ مهندسی مدرن (CI/CD, DevOps).

-

حمایت مدیران ارشد برای تغییر ساختار سازمانی.

فاز ۲: انتخاب پروژههای فانوس دریایی (Lighthouse Projects)

به جای تغییر کل سازمان، با یک یا دو دامنه شروع کنید که:

-

اهمیت استراتژیک دارند.

-

تیم فنی قوی دارند.

-

نیاز شدید به دادههای تحلیلی دارند.

این دامنهها به عنوان الگوی موفقیت برای بقیه سازمان عمل خواهند کرد.

فاز ۳: ساخت پلتفرم حداقلی (MVP Platform)

تیم پلتفرم باید ابزارهای اولیهای را فراهم کند که به دامنههای پایلوت اجازه دهد:

-

یک مخزن داده ایجاد کنند.

-

دسترسیها را مدیریت کنند.

-

متادیتای محصول خود را ثبت کنند.

فاز ۴: گسترش و فدرالیسم

پس از موفقیت پایلوتها، مدل را به سایر دامنهها گسترش دهید و کمیته حاکمیت فدرال را برای تعیین استانداردها تشکیل دهید.

۷. تغییرات سازمانی و نقشهای جدید

موفقیت دیتا مش ۵۰٪ تکنیکال و ۵۰٪ فرهنگی است. نقشهای جدیدی باید تعریف شوند:

۱. مالک محصول داده (Domain Data Product Owner)

این فرد در تیم دامنه (مثلاً تیم سفارشات) حضور دارد. او مسئول ویژن محصول داده، نقشه راه، و کیفیت دادههاست. او باید مطمئن شود که دادههای تیمش برای مصرفکنندگان قابل استفاده و ارزشمند است.

۲. مهندس داده دامنه (Domain Data Engineer)

به جای اینکه مهندسان داده در یک تیم مرکزی ایزوله باشند، آنها در تیمهای دامنه پخش میشوند (Embedded). آنها با استفاده از ابزارهای پلتفرم، پایپلاینهای ETL/ELT خاص آن دامنه را میسازند.

۳. مهندس پلتفرم داده (Data Platform Engineer)

این افراد مسئول ساخت و نگهداری زیرساخت سلفسرویس هستند. مشتریان آنها، مهندسان دادهی دامنهها هستند. ذهنیت آنها باید “Product Mindset” باشد، نه “Ticket taking”.

۸. تکنولوژیهای زیستبوم دیتا مش

اگرچه دیتا مش وابسته به ابزار خاصی نیست، اما برخی ابزارها با این معماری همخوانی بیشتری دارند:

-

ذخیرهسازی و پردازش: Snowflake, Databricks Delta Lake, Google BigQuery (به دلیل قابلیت جداسازی Compute/Storage و امکان اشتراکگذاری داده).

-

کاتالوگ داده: Alation, Collibra, Amundsen, DataHub (برای کشفپذیری).

-

ارکستراسیون: Airflow, Dagster, Prefect (برای مدیریت پایپلاینها).

-

کیفیت داده: Great Expectations, Monte Carlo.

-

تبدیل داده: dbt (Data Build Tool) – ابزاری حیاتی که به تحلیلگران اجازه میدهد با SQL مهندسی داده انجام دهند.

-

سیاست به عنوان کد (Policy as Code): Open Policy Agent (OPA).

۹. چالشها و نقدهای وارده بر دیتا مش

هیچ معماری بینقص نیست. دیتا مش نیز چالشهای سنگینی دارد:

۹.۱. پیچیدگی و سربار (Overhead)

توزیع کردن مسئولیتها نیازمند این است که هر تیم دامنه، دانش فنی مدیریت داده را داشته باشد. این میتواند باعث دوبارهکاری (Duplication) و هدررفت منابع شود اگر پلتفرم سلفسرویس به درستی کار نکند.

۹.۲. کابوس یکپارچگی (Integration Nightmare)

بدون حاکمیت فدرال قوی، دیتا مش میتواند به سرعت به “سیلوهای داده توزیع شده” تبدیل شود که در آن هر تیم با استانداردهای خودش کار میکند و هیچ کس نمیتواند دادههای کل سازمان را یکپارچه (Join) کند.

۹.۳. کمبود استعداد

پیدا کردن مهندسان داده به اندازه کافی دشوار است؛ پیدا کردن مهندسان دادهای که هم دانش دامنه داشته باشند و هم دانش زیرساختی، و توزیع آنها در تمام تیمها، چالشی بزرگ برای منابع انسانی است.

۹.۴. مقیاس سازمانی

دیتا مش برای استارتاپهای کوچک یا سازمانهایی با پیچیدگی داده کم مناسب نیست. اگر شما ۳ مهندس داده دارید، دیتا مش برای شما “Over-engineering” محض است.

۱۰. آینده حاکمیت داده و نتیجهگیری

دیتا مش پاسخی به پیچیدگی فزایندهی سازمانهای دیجیتال است. این معماری اذعان میکند که ما نمیتوانیم واقعیت پیچیده و متغیر کسبوکار را در یک مدل مرکزی واحد محبوس کنیم.

گذار به دیتا مش، گذار از “کنترل مرکزی” به “هماهنگی توزیعشده” است.

برای سازمانهایی که قصد حرکت در این مسیر را دارند، پیام اصلی این است: روی افراد و تعاملات تمرکز کنید، نه فقط ابزارها. پلتفرم فنی باید در خدمت توانمندسازی دامنهها باشد تا آنها بتوانند دادههای خود را به عنوان یک محصول با کیفیت ارائه دهند.

در آینده، انتظار میرود که مرز بین “توسعه نرمافزار” و “توسعه داده” کاملاً محو شود. همانطور که امروز هیچ توسعهدهندهای نمیگوید “من مسئول لاگهای اپلیکیشن نیستم”، در آینده نیز هیچ توسعهدهندهای نخواهد گفت “من مسئول دادههای تحلیلی سرویس خود نیستم”. دیتا مش زیربنای این آینده است.

واژهنامه تخصصی (Glossary)

-

Silo (سیلو): مخازن داده ایزوله که دسترسی به آنها دشوار است.

-

Domain-Driven Design (DDD): رویکردی در توسعه نرمافزار که بر اساس مدلسازی واقعی کسبوکار است.

-

Polyglot Storage: استفاده از انواع مختلف تکنولوژیهای ذخیرهسازی برای نیازهای مختلف.

-

ETL vs ELT: تفاوت در زمان تبدیل داده (قبل از بارگذاری یا بعد از بارگذاری).

-

Data Lineage: ردگیری مسیر حرکت و تغییرات داده از مبدا تا مقصد.

-

SLA (Service Level Agreement): توافقنامه سطح خدمات (تعهد رسمی).

-

SLO (Service Level Objective): اهداف سطح خدمات (اهداف فنی قابل اندازهگیری).

ممنون بابت مطلب خوبتون.

عالی توضیح دادید دمتون گرم!

حتماً بازم از این مطالب میذارید؟