مقدمه: اهمیت کیفیت داده در عصر هوش مصنوعی و تحلیلهای پیشرفته

در دنیای امروز، داده به عنوان “نفت جدید” شناخته میشود — منبع ارزشمندی که بدون پالایش و مدیریت صحیح، نه تنها ارزشآفرین نخواهد بود، بلکه میتواند باعث تصمیمات نادرست، هدررفت منابع و حتی خطرات قانونی و اخلاقی شود. در سازمانهای بزرگ و متوسط، که از سیستمهای چندگانه (ERP, CRM, SCM, Data Warehouses, Data Lakes, APIs و غیره) تغذیه میشوند، حفظ کیفیت داده (Data Quality) یک چالش فنی، سازمانی و استراتژیک است.

با رشد استفاده از هوش مصنوعی، یادگیری ماشین، تحلیلهای پیشبینیکننده و سیستمهای خودکار، اهمیت کیفیت داده بیش از پیش افزایش یافته است. یک مدل ML که بر اساس دادههای نامعتبر آموزش دیده باشد، میتواند در محیط تولید (Production) عملکردی غلط و گاه خطرناک ارائه دهد — و این موضوع، مسؤلیت اصلی مهندسان داده است.

در این مقاله، با رویکردی مهندسی داده (Data Engineering)، به بررسی ابزارهای کاربردی و مدرن برای مانیتورینگ کیفیت داده در سازمانها میپردازیم. این ابزارها شامل ابزارهای آشکارسازی خطاهای داده، تشخیص انحرافات، نظارت بر سلامت دادهها، مدیریت متادیتا، ارزیابی صحت و کامل بودن دادهها و همچنین یکپارچهسازی با خطوط لوله داده (Data Pipelines) هستند.

این مقاله شامل بخشهای زیر است:

- تعریف کیفیت داده و معیارهای آن

- چالشهای مانیتورینگ کیفیت داده در محیطهای سازمانی

- معماری مهندسی داده برای مانیتورینگ کیفیت داده

- ابزارهای کلیدی برای مانیتورینگ کیفیت داده (با جزئیات فنی و مقایسه)

- ادغام ابزارها با خطوط لوله داده (ETL/ELT, Streaming, Batch)

- نمونههای عملی و موردی (Case Studies)

- بهترین شیوهها و استانداردها

- چشمانداز آینده و روندهای نوظهور

۱. تعریف کیفیت داده و معیارهای آن

۱.۱. کیفیت داده چیست؟

کیفیت داده به میزان قابلیت اعتماد، صحت، کامل بودن، متناسب بودن، ثبات و بهروز بودن دادهها اشاره دارد. این مفهوم فقط شامل دقت عددی نیست، بلکه شامل معنای داده، سازگاری با استانداردها، قابلیت استفاده برای تصمیمگیری و سازگاری با نیازهای کسبوکار نیز میشود.

در ادبیات مهندسی داده، کیفیت داده با استانداردهایی مانند DAMA-DMBOK، ISO 8000 و TDWI تعریف میشود.

۱.۲. معیارهای کیفیت داده (Data Quality Dimensions)

طبق استانداردهای صنعتی، کیفیت داده از چند بعد ارزیابی میشود:

✅ ۱. دقت (Accuracy)

دادهها باید با واقعیت مطابقت داشته باشند. مثال: یک مشتری با نام “علی محمدی” نباید در سیستم با نام “علی محمدیی” ثبت شود.

✅ ۲. کامل بودن (Completeness)

تمامی فیلدهای ضروری باید پر شده باشند. مثال: در یک رکورد مشتری، فیلد “شماره تماس” نباید خالی باشد.

✅ ۳. ثبات (Consistency)

دادهها در سراسر سیستمها باید یکسان باشند. مثال: یک کد مشتری در ERP و CRM باید یکسان باشد.

✅ ۴. بهروز بودن (Timeliness)

دادهها باید در زمان مناسب و با تأخیر قابل قبول در دسترس باشند. مثال: دادههای فروش روزانه باید ظهر روز بعد در داشبورد در دسترس باشند.

✅ ۵. متناسب بودن (Relevance)

دادهها باید برای هدف استفاده مناسب باشند. مثال: استفاده از دادههای قدیمی برای پیشبینی تقاضا در بازار فعلی ممکن است نامناسب باشد.

✅ ۶. قابلیت استفاده (Usability)

دادهها باید به شکلی باشند که کاربران (تحلیلگران، مدیران، مدلهای ML) بتوانند از آنها استفاده کنند. مثال: فرمت دادهها باید قابل خواندن و استاندارد باشد.

✅ ۷. یکپارچگی (Integrity)

دادهها باید از نظر منطقی و روابطی (مثلاً FK-PK در دیتابیس) سالم باشند.

✅ ۸. قابلیت ردیابی (Traceability)

باید بتوان منبع و تاریخچه تغییرات داده را ردیابی کرد.

۲. چالشهای مانیتورینگ کیفیت داده در محیطهای سازمانی

در سازمانهای بزرگ، مانیتورینگ کیفیت داده با چالشهای فراوانی روبهرو است:

۲.۱. تعدد منابع داده (Data Silos)

سازمانها از سیستمهای مختلف (CRM, ERP, HRMS, Web Analytics, IoT, External APIs) تغذیه میشوند. هر سیستم ممکن است فرمت، ساختار و کیفیت داده متفاوتی داشته باشد.

🔍 مشکل: یکپارچهسازی و ارزیابی کیفیت در چنین محیطهایی بسیار پیچیده است.

۲.۲. حجم بالا و سرعت ورود داده (Big Data & Streaming)

در محیطهای Real-time یا Batch با حجم بالا، ارزیابی کیفیت داده در زمان واقعی یا با تأخیر کم، چالشی فنی است.

🚀 مثال: در یک سیستم تراکنشهای بانکی، تشخیص خطاهای داده باید در کمتر از ۱ ثانیه انجام شود.

۲.۳. عدم وجود استانداردها و متادیتا

بسیاری از سازمانها متادیتا (Metadata) مناسبی ندارند — بنابراین تشخیص “داده خراب” یا “داده غیرمنتظره” دشوار است.

۲.۴. تغییرات در ساختار داده (Schema Evolution)

در محیطهای Data Lake یا NoSQL، ساختار دادهها ممکن است به طور مداوم تغییر کند. این موضوع باعث میشود که قوانین کیفیت داده نیاز به بهروزرسانی مداوم داشته باشند.

۲.۵. عدم هماهنگی بین تیمها

تیمهای داده، توسعه، عملیات و کسبوکار اغلب اهداف و معیارهای متفاوتی دارند. این عدم هماهنگی باعث میشود که مسئولیت کیفیت داده به صورت پراکنده و ناکارآمد مدیریت شود.

۲.۶. عدم اتوماسیون و وابستگی به دستی

بسیاری از سازمانها هنوز از اسکریپتهای دستی یا اکسل برای بررسی کیفیت داده استفاده میکنند — که مقیاسپذیر نیستند و احتمال خطا را افزایش میدهند.

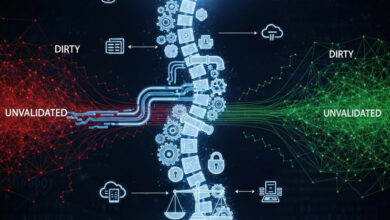

۳. معماری مهندسی داده برای مانیتورینگ کیفیت داده

برای حل چالشهای فوق، یک معماری مهندسی داده منظم و اتوماتیک برای مانیتورینگ کیفیت داده ضروری است. این معماری شامل لایههای زیر است:

۳.۱. لایه جمعآوری داده (Ingestion Layer)

- ETL/ELT Tools: Apache NiFi, Talend, Informatica, Fivetran, Airbyte

- Streaming Ingestion: Kafka, Kinesis, Pulsar

- File Ingestion: S3, ADLS, GCS

💡 این لایه باید قبل از ورود داده به خط لوله، تشخیص اولیه خطاها را انجام دهد (مثلاً فایل خالی، فرمت نادرست).

۳.۲. لایه پیشپردازش و اعتبارسنجی (Validation & Preprocessing Layer)

- اعتبارسنجی ساختاری (Schema Validation): با استفاده از Avro, Protobuf, JSON Schema

- اعتبارسنجی محتوایی (Content Validation): بررسی مقادیر، فرمتها، محدودهها

- ابزارهای اعتبارسنجی: Great Expectations, Pandas Profiling, Deequ, Soda Core

⚙️ این لایه میتواند درون خط لوله (Pipeline) یا به صورت جداگانه اجرا شود.

۳.۳. لایه ذخیرهسازی (Storage Layer)

- Data Lake: Delta Lake, Iceberg, Hudi

- Data Warehouse: Snowflake, BigQuery, Redshift, Databricks

- Operational DBs: PostgreSQL, MySQL, MongoDB

📦 در این لایه، متادیتا و تاریخچه تغییرات داده باید ذخیره شود.

۳.۴. لایه مانیتورینگ و هشدار (Monitoring & Alerting Layer)

- ابزارهای مانیتورینگ: Prometheus + Grafana, Datadog, Evidently AI, Monte Carlo, Soda Cloud

- هشدارها: Slack, Email, PagerDuty, Microsoft Teams

- ** Dashboards**: Metabase, Superset, Tableau, Power BI (برای نمایش کیفیت داده)

🚨 این لایه باید قادر باشد خطاهای داده را در زمان واقعی یا دورهای تشخیص دهد و هشدار ارسال کند.

۳.۵. لایه مدیریت متادیتا و کاتالوگ (Metadata & Catalog Layer)

- Data Catalogs: Apache Atlas, Amundsen, DataHub, Alation

- Lineage Tracking: Marquez, OpenLineage, Databricks Unity Catalog

🧭 این لایه به مهندسان داده کمک میکند تا منبع داده، تغییرات و تأثیرات آن را ردیابی کنند.

۳.۶. لایه اقدام و بازآموزی (Action & Retraining Layer)

- Auto-remediation: اصلاح خودکار دادههای خراب (مثلاً با جایگزینی مقدار پیشفرض)

- Retraining Models: اگر کیفیت داده برای مدل ML کاهش یافت، بازآموزی خودکار

- Workflow Automation: Airflow, Prefect, Dagster

🔁 این لایه ارتباط مستقیمی با MLOps و DataOps دارد.

۴. ابزارهای کلیدی برای مانیتورینگ کیفیت داده (با جزئیات فنی و مقایسه)

در ادامه، به بررسی ۱۰ ابزار کاربردی و مدرن برای مانیتورینگ کیفیت داده میپردازیم. هر ابزار را از نظر ویژگیها، مزایا، معایب، موارد استفاده و یکپارچهسازی بررسی میکنیم.

۴.۱. Great Expectations

📍 توضیح:

یک کتابخانه Python باز میباشد که به مهندسان داده اجازه میدهد انتظارات (Expectations) در مورد دادهها را تعریف کنند — مثلاً “ستون سن باید بین ۱۸ تا ۱۰۰ باشد” یا “هیچ مقدار null در ستون ایمیل وجود نداشته باشد”.

✅ ویژگیها:

- تعریف انتظارات با کد (Code-based)

- ایجاد گزارشهای بصری (Data Docs)

- ادغام با Airflow, Databricks, Spark

- پشتیبانی از Batch و Streaming

- امکان ایجاد Checkpoints برای اعتبارسنجی

⚠️ معایب:

- نیاز به دانش برنامهنویسی Python

- پیچیدگی در پیادهسازی برای تیمهای غیرفنی

- نیاز به مدیریت و نگهداری اسکریپتها

🎯 موارد استفاده:

- اعتبارسنجی دادههای ورودی در خطوط لوله ETL

- تستهای واحد (Unit Tests) برای دادهها

- ایجاد گزارشهای کیفیت داده برای تیمهای تحلیلی

🔄 یکپارچهسازی:

- با Airflow: از طریق

GreatExpectationsOperator - با Databricks: از طریق نوتبوکهای PySpark

- با GitHub: برای مدیریت نسخههای انتظارات

۴.۲. Soda Core / Soda Cloud

📍 توضیح:

Soda یک پلتفرم باز (Open Source) و تجاری است که برای تشخیص خطاهای داده و مانیتورینگ کیفیت طراحی شده است. Soda Core نسخه باز است و Soda Cloud نسخه تجاری با قابلیتهای بیشتر.

✅ ویژگیها:

- تعریف قوانین کیفیت داده با YAML (بدون نیاز به کدنویسی)

- پشتیبانی از تمام پلتفرمهای داده (Snowflake, BigQuery, Redshift, Postgres, Spark, Databricks)

- تشخیص انحرافات (Drift Detection)

- ارسال هشدار از طریق Slack, Email, PagerDuty

- گزارشهای بصری و داشبوردها

⚠️ معایب:

- نسخه باز (Core) قابلیتهای محدودی دارد

- نیاز به پیکربندی اولیه برای هر منبع داده

- ممکن است برای سازمانهای بسیار بزرگ نیاز به سرور اختصاصی داشته باشد

🎯 موارد استفاده:

- مانیتورینگ کیفیت داده در Data Lake و Data Warehouse

- تشخیص انحرافات در دادههای تراکنشی

- ادغام با CI/CD برای تست دادهها

🔄 یکپارچهسازی:

- با Airflow: از طریق

SodaOperator - با GitHub Actions: برای اجرای تستهای داده در هر commit

- با Slack: برای ارسال هشدارهای خودکار

۴.۳. Amazon Deequ

📍 توضیح:

توسعهیافته توسط آمازون، Deequ یک کتابخانه Scala/Python برای ارزیابی کیفیت داده در Spark است. این ابزار برای سازمانهایی که از Spark استفاده میکنند، بسیار کاربردی است.

✅ ویژگیها:

- ارزیابی خودکار کیفیت داده (Automatic Profiling)

- تشخیص خطاهای آماری (مثلاً توزیع نامتعادل)

- پشتیبانی از Spark SQL و DataFrame

- ایجاد گزارشهای HTML

- امکان ایجاد قوانین سفارشی

⚠️ معایب:

- فقط برای Spark مناسب است

- نیاز به دانش Scala/Python

- پشتیبانی محدود در محیطهای غیر-Spark

🎯 موارد استفاده:

- ارزیابی کیفیت داده در خطوط لوله Spark

- تشخیص خطاهای آماری در دادههای بزرگ

- ایجاد گزارشهای کیفیت برای تیمهای تحلیلی

🔄 یکپارچهسازی:

- با AWS Glue: برای اجرای تستهای کیفیت در ETL

- با EMR: برای اجرای Deequ در کلاستر Spark

- با S3: برای ذخیره گزارشها

۴.۴. Evidently AI

📍 توضیح:

Evidently یک ابزار باز است که برای مقایسه دادهها و تشخیص انحرافات (Data Drift, Model Drift) طراحی شده است. این ابزار بیشتر برای تیمهای ML و Data Science مناسب است.

✅ ویژگیها:

- تشخیص Data Drift و Model Drift

- ایجاد گزارشهای بصری (HTML, Dashboard)

- پشتیبانی از Pandas, Scikit-learn, TensorFlow, PyTorch

- امکان ادغام با MLflow و Weights & Biases

- امکان اجرای در محیط Real-time

⚠️ معایب:

- تمرکز اصلی بر روی ML، نه کیفیت داده عمومی

- نیاز به دادههای مرجع (Reference Dataset)

- ممکن است برای کیفیت دادههای عملیاتی (Operational Data) کمتر مناسب باشد

🎯 موارد استفاده:

- تشخیص انحرافات در دادههای ورودی مدل ML

- نظارت بر عملکرد مدل در محیط تولید

- ایجاد گزارشهای کیفیت برای تیمهای ML

🔄 یکپارچهسازی:

- با MLflow: برای ذخیره گزارشهای Evidently

- با Docker: برای استقرار در محیط تولید

- با Airflow: برای اجرای دورهای تستها

۴.۵. Monte Carlo

📍 توضیح:

Monte Carlo یک پلتفرم تجاری است که به صورت End-to-End کیفیت داده را در سازمانها مانیتور میکند. این ابزار برای سازمانهای بزرگ و پیچیده طراحی شده است.

✅ ویژگیها:

- تشخیص خودکار خطاها و انحرافات

- ردیابی خطای داده از منبع تا مقصد (Lineage-Based Monitoring)

- هشدارهای هوشمند و اتوماتیک

- داشبوردهای کیفیت داده

- ادغام با ابزارهای محبوب (Snowflake, BigQuery, Databricks, Looker, Tableau)

⚠️ معایب:

- هزینه بالا (تجاری)

- نیاز به پیکربندی اولیه پیچیده

- ممکن است برای سازمانهای کوچک بیش از حد باشد

🎯 موارد استفاده:

- مانیتورینگ کیفیت داده در سازمانهای بزرگ

- تشخیص خطاها در خطوط لوله پیچیده

- گزارشدهی به مدیران و ذینفعان

🔄 یکپارچهسازی:

- با Snowflake, BigQuery, Redshift: از طریق connectorهای رسمی

- با Slack, Teams, Email: برای هشدارهای خودکار

- با Data Catalogs: برای ردیابی خطای داده

۴.۶. Apache Griffin

📍 توضیح:

Griffin یک پروژه Apache باز است که برای اندازهگیری و مانیتورینگ کیفیت داده در محیطهای Big Data طراحی شده است. این ابزار برای سازمانهایی که از Hadoop, Spark, Hive استفاده میکنند، مناسب است.

✅ ویژگیها:

- پشتیبانی از Batch و Streaming

- ارزیابی کیفیت داده بر اساس قوانین (Rules)

- ایجاد گزارشهای آماری

- ادغام با Hadoop Ecosystem

⚠️ معایب:

- پیچیدگی در نصب و پیکربندی

- نیاز به دانش Java/Scala

- پشتیبانی محدود در محیطهای مدرن (مثل Cloud Data Warehouses)

🎯 موارد استفاده:

- مانیتورینگ کیفیت داده در محیطهای Hadoop

- ارزیابی دادههای Batch در خطوط لوله Spark/Hive

- گزارشدهی به تیمهای عملیاتی

🔄 یکپارچهسازی:

- با Hive, Spark, HDFS: از طریق connectorهای داخلی

- با REST API: برای ارسال نتایج به سیستمهای دیگر

۴.۷. Pandas Profiling (Sweetviz, Dora)

📍 توضیح:

این ابزارها برای ایجاد گزارشهای خودکار از دادهها (Profiling) طراحی شدهاند. Pandas Profiling یک کتابخانه Python است که گزارشهای HTML جامعی از دادهها ایجاد میکند.

✅ ویژگیها:

- ایجاد گزارشهای خودکار (Statistical Summary, Missing Values, Duplicates, Correlations)

- ساده و سریع برای استفاده

- مناسب برای تحلیل اولیه دادهها

⚠️ معایب:

- فقط برای دادههای کوچک مناسب است (تا چند میلیون رکورد)

- قابلیتهای محدود در تشخیص خطاهای پیچیده

- نیاز به اجرای دستی (غیراتوماتیک)

🎯 موارد استفاده:

- تحلیل اولیه دادهها در مرحله EDA

- گزارشدهی به تیمهای تحلیلی

- تشخیص سریع خطاهای داده در دادههای نمونه

🔄 یکپارچهسازی:

- با Jupyter Notebook: برای ایجاد گزارشهای تعاملی

- با GitHub: برای ذخیره گزارشها

۴.۸. Datadog Data Monitoring

📍 توضیح:

Datadog یک پلتفرم مانیتورینگ کلی است که اکنون قابلیتهای Data Monitoring را نیز ارائه میدهد. این ابزار برای سازمانهایی که از Datadog برای مانیتورینگ اپلیکیشنها استفاده میکنند، مناسب است.

✅ ویژگیها:

- مانیتورینگ کیفیت داده در Real-time

- تشخیص انحرافات و خطاها

- هشدارهای هوشمند

- داشبوردهای یکپارچه با سایر سیستمها

⚠️ معایب:

- هزینه بالا

- نیاز به پیکربندی پیچیده

- ممکن است برای کیفیت دادههای تخصصی کمتر مناسب باشد

🎯 موارد استفاده:

- مانیتورینگ کیفیت داده در محیطهای Real-time

- یکپارچهسازی با سیستمهای موجود (APIs, Databases, Applications)

- گزارشدهی به تیمهای DevOps و Data

🔄 یکپارچهسازی:

- با Snowflake, BigQuery, Redshift: از طریق connectorهای رسمی

- با Slack, PagerDuty: برای هشدارهای خودکار

۴.۹. OpenLineage + Marquez

📍 توضیح:

OpenLineage یک استاندارد باز برای ردیابی خطای داده (Data Lineage) است. Marquez یک ابزار باز است که از OpenLineage پشتیبانی میکند و برای ردیابی جریان دادهها از منبع تا مقصد طراحی شده است.

✅ ویژگیها:

- ردیابی کامل جریان دادهها

- تشخیص منبع خطاها

- ادغام با Airflow, Spark, Databricks

- پشتیبانی از Metadata

⚠️ معایب:

- نیاز به پیکربندی پیچیده

- نیاز به دانش فنی بالا

- ممکن است برای سازمانهای کوچک بیش از حد باشد

🎯 موارد استفاده:

- ردیابی خطای داده در خطوط لوله پیچیده

- تشخیص منبع خطاها در دادههای خراب

- گزارشدهی به مدیران و ذینفعان

🔄 یکپارچهسازی:

- با Airflow: از طریق OpenLineage Operator

- با Spark: از طریق OpenLineage Listener

- با Databricks: از طریق Unity Catalog

۴.۱۰. Datafold

📍 توضیح:

Datafold یک ابزار تجاری است که برای مقایسه دادهها (Data Diff) طراحی شده است. این ابزار برای تشخیص تفاوتهای دادهها در بین دو محیط (مثلاً Development و Production) بسیار کاربردی است.

✅ ویژگیها:

- مقایسه دادهها در سطح ستون و رکورد

- تشخیص تفاوتهای آماری

- ایجاد گزارشهای بصری

- ادغام با Git, CI/CD

⚠️ معایب:

- هزینه بالا

- فقط برای مقایسه دادهها مناسب است (نه برای مانیتورینگ مداوم)

- نیاز به دادههای مرجع

🎯 موارد استفاده:

- تشخیص تفاوتهای داده در بین محیطهای Development و Production

- تستهای Regression برای دادهها

- گزارشدهی به تیمهای توسعه

🔄 یکپارچهسازی:

- با GitHub: برای اجرای تستهای Data Diff در هر pull request

- با Airflow: برای اجرای دورهای مقایسه دادهها

۵. ادغام ابزارها با خطوط لوله داده (ETL/ELT, Streaming, Batch)

برای اینکه ابزارهای مانیتورینگ کیفیت داده مؤثر باشند، باید به صورت اتوماتیک و یکپارچه در خطوط لوله داده ادغام شوند. در ادامه، روشهای ادغام را بر اساس نوع خط لوله بررسی میکنیم.

۵.۱. خطوط لوله Batch (ETL/ELT)

در خطوط لوله Batch، معمولاً دادهها به صورت دورهای (مثلاً روزانه یا هفتگی) پردازش میشوند. در این محیطها، میتوان از ابزارهایی مانند Great Expectations, Soda Core, Deequ و Apache Griffin استفاده کرد.

مثال: ادغام Great Expectations با Airflow

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

from great_expectations.dataset.sparkdf_dataset import SparkDFDataset

from pyspark.sql import SparkSession

def validate_data():

spark = SparkSession.builder.getOrCreate()

df = spark.read.parquet("s3://my-bucket/data.parquet")

ge_df = SparkDFDataset(df)

results = ge_df.expect_column_values_to_not_be_null("email")

if not results["success"]:

raise Exception("Validation failed!")

dag = DAG('data_validation', schedule_interval='@daily')

validate_task = PythonOperator(task_id='validate_data', python_callable=validate_data, dag=dag)

۵.۲. خطوط لوله Streaming

در محیطهای Streaming (مثلاً Kafka, Kinesis)، نیاز به مانیتورینگ در زمان واقعی است. در این محیطها، ابزارهایی مانند Evidently AI, Datadog Data Monitoring و Soda Cloud مناسبتر هستند.

مثال: ادغام Evidently با Kafka

from kafka import KafkaConsumer

import json

from evidently.report import Report

from evidently.metrics import DataDriftTable

consumer = KafkaConsumer('raw-data', bootstrap_servers='localhost:9092')

for message in consumer:

data = json.loads(message.value)

report = Report(metrics=[DataDriftTable()])

report.save_html("drift_report.html")

# Send alert if drift detected

۵.۳. خطوط لوله ELT در Data Warehouse

در محیطهای Modern Data Stack (Snowflake, BigQuery, Redshift)، ابزارهایی مانند Soda Cloud, Monte Carlo و Datafold بسیار کاربردی هستند — زیرا مستقیماً با این پلتفرمها یکپارچه میشوند.

مثال: ادغام Soda Cloud با Snowflake

# sodacl.yaml

checks for snowflake_table:

- row_count > 0

- missing_count(email) = 0

- distinct_count(user_id) > 1000

سپس با اجرای دستور:

soda scan configuration.yml sodacl.yaml

۶. نمونههای عملی و موردی (Case Studies)

۶.۱. موردی: شرکت فناوری مالی (Fintech)

مشکل: در یک شرکت Fintech، دادههای تراکنشهای مالی در محیط تولید با خطاهایی مواجه شدند — مثلاً مبالغ منفی، کدهای مشتری تکراری و تاریخهای نادرست.

راهحل:

- استفاده از Soda Core برای تعریف قوانین کیفیت داده

- ادغام با Airflow برای اجرای دورهای تستها

- ارسال هشدار از طریق Slack به تیم عملیاتی

نتیجه: کاهش ۹۰٪ خطاهای داده، افزایش اعتماد مدیران به دادهها و کاهش زمان پاسخ به مشکلات.

۶.۲. موردی: شرکت فروشگاه آنلاین

مشکل: دادههای محصولات در Data Warehouse با دادههای CRM همخوانی نداشتند — مثلاً قیمتها و موجودیها متفاوت بودند.

راهحل:

- استفاده از OpenLineage + Marquez برای ردیابی جریان دادهها

- استفاده از Datafold برای مقایسه دادهها در بین محیطها

- ایجاد گزارشهای هفتگی برای تیمهای بازاریابی

نتیجه: هماهنگی کامل بین سیستمها، کاهش خطاهای گزارشدهی و افزایش فروش به دلیل اعتماد به دادهها.

۶.۳. موردی: شرکت هوش مصنوعی (AI Startup)

مشکل: مدل ML برای پیشبینی تقاضا، به دلیل انحراف در دادههای ورودی، عملکرد ضعیفی داشت.

راهحل:

- استفاده از Evidently AI برای تشخیص Data Drift

- ادغام با MLflow برای ذخیره گزارشها

- ایجاد Workflow در Prefect برای بازآموزی خودکار مدل

نتیجه: افزایش دقت مدل از ۷۵٪ به ۹۲٪، کاهش زمان پاسخ به انحرافات داده از ۲ هفته به ۲ ساعت.

۷. بهترین شیوهها و استانداردها

برای موفقیت در مانیتورینگ کیفیت داده، رعایت بهترین شیوهها ضروری است:

۷.۱. تعریف معیارهای کیفیت داده (Data Quality Rules)

- قوانین باید شفاف، قابل اندازهگیری و قابل اجرا باشند.

- از ابزارهایی مانند Great Expectations یا Soda برای تعریف قوانین استفاده کنید.

۷.۲. اتوماسیون تستهای داده

- تستهای کیفیت داده باید به صورت خودکار و دورهای اجرا شوند.

- از ابزارهایی مانند Airflow, Prefect, Dagster برای اتوماسیون استفاده کنید.

۷.۳. ایجاد گزارشهای بصری و داشبوردها

- گزارشها باید قابل فهم برای غیرفنیها باشند.

- از ابزارهایی مانند Grafana, Metabase, Tableau برای ایجاد داشبوردها استفاده کنید.

۷.۴. ردیابی خطای داده (Data Lineage)

- هر خطا باید به منبع آن ردیابی شود.

- از ابزارهایی مانند OpenLineage, Marquez, Monte Carlo استفاده کنید.

۷.۵. هشدارهای هوشمند و اقدامات خودکار

- هشدارها باید در زمان مناسب و به شخص مناسب ارسال شوند.

- اقدامات خودکار (مثلاً اصلاح داده یا بازآموزی مدل) باید تعریف شوند.

۷.۶. آموزش و فرهنگ کیفیت داده

- تمام تیمها (تحلیلگران، توسعهدهندگان، مدیران) باید با اهمیت کیفیت داده آشنا باشند.

- دورههای آموزشی و مستندات واضح ضروری است.

۸. چشمانداز آینده و روندهای نوظهور

۸.۱. هوش مصنوعی برای مانیتورینگ کیفیت داده

در آینده، ابزارهای مانیتورینگ کیفیت داده با استفاده از هوش مصنوعی و یادگیری ماشین، قادر خواهند بود:

- تشخیص خودکار خطاهای جدید (بدون نیاز به تعریف قانون)

- پیشبینی خطاها قبل از وقوع

- پیشنهاد راهحلهای خودکار برای اصلاح دادهها

۸.۲. یکپارچهسازی با MLOps و DataOps

مانیتورینگ کیفیت داده به یک بخش اساسی از MLOps و DataOps تبدیل خواهد شد. ابزارهایی مانند Evidently, Soda, Monte Carlo به صورت یکپارچه با خطوط لوله ML و Data ادغام خواهند شد.

۸.۳. استانداردسازی و ابزارهای باز

استانداردهایی مانند OpenLineage و Data Contract در حال گسترش هستند. این استانداردها به سازمانها کمک میکنند تا کیفیت داده را به صورت یکپارچه و استاندارد مدیریت کنند.

۸.۴. افزایش تمرکز بر اخلاق و عدالت داده

در آینده، کیفیت داده فقط شامل دقت و کامل بودن نخواهد بود، بلکه شامل عدالت، شفافیت و اخلاق نیز خواهد بود. ابزارهایی که قادر به تشخیص تبعیض در دادهها هستند، بیشتر مورد استقبال قرار خواهند گرفت.

نتیجهگیری: کیفیت داده، پایهای برای موفقیت سازمانی

در عصر داده، کیفیت داده نه یک چالش فنی، بلکه یک مسئله استراتژیک است. سازمانهایی که بتوانند کیفیت دادههای خود را به صورت مداوم و اتوماتیک مانیتور کنند، میتوانند:

- تصمیمات بهتری بگیرند

- مدلهای ML دقیقتری داشته باشند

- هزینههای عملیاتی را کاهش دهند

- اعتماد مشتریان و ذینفعان را افزایش دهند

ابزارهای مدرن مانند Great Expectations, Soda, Evidently, Monte Carlo و OpenLineage به مهندسان داده کمک میکنند تا این چالش را به صورت سیستماتیک و مقیاسپذیر مدیریت کنند.

🎯 به یاد داشته باشید: “دادههای خوب، ارزشآفرین هستند — دادههای بد، هزینهآور و خطرناک.”

پیوست: جدول مقایسه ابزارهای مانیتورینگ کیفیت داده

| ابزار | نوع | پلتفرم پشتیبانی شده | اتوماسیون | هشدار | یکپارچهسازی | هزینه |

|---|---|---|---|---|---|---|

| Great Expectations | Open Source | All (Python) | ✅ | ❌ | Airflow, Databricks | رایگان |

| Soda Core | Open Source | All (YAML) | ✅ | ✅ | Airflow, GitHub | رایگان |

| Soda Cloud | Commercial | All | ✅ | ✅ | Slack, Teams, Snowflake | پولی |

| Amazon Deequ | Open Source | Spark | ✅ | ❌ | AWS Glue, EMR | رایگان |

| Evidently AI | Open Source | ML Frameworks | ✅ | ✅ | MLflow, Airflow | رایگان |

| Monte Carlo | Commercial | All | ✅ | ✅ | Snowflake, BigQuery, Slack | پولی |

| Apache Griffin | Open Source | Hadoop Ecosystem | ✅ | ❌ | Hive, Spark | رایگان |

| Pandas Profiling | Open Source | Pandas | ❌ | ❌ | Jupyter | رایگان |

| Datadog Data Monitoring | Commercial | All | ✅ | ✅ | Slack, PagerDuty | پولی |

| OpenLineage + Marquez | Open Source | Airflow, Spark | ✅ | ❌ | Airflow, Databricks | رایگان |

| Datafold | Commercial | All | ✅ | ✅ | GitHub, CI/CD | پولی |

پیشنهادات برای اقدام فوری

- شروع با یک ابزار ساده مانند Great Expectations یا Soda Core.

- تعریف ۳ تا ۵ قانون کیفیت داده برای یک جدول کلیدی.

- ادغام با خط لوله (مثلاً Airflow) برای اجرای دورهای.

- ایجاد یک داشبورد برای نمایش وضعیت کیفیت داده.

- آموزش تیم و ایجاد فرهنگ کیفیت داده.